| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- deep daiv. 2주차 팀 활동 과제

- deep daiv. project_paper

- deep daiv. week3 팀활동과제

- deep daiv. week4 팀활동과제

- deep daiv. WIL

- Today

- Total

OK ROCK

🌊deep daiv. 프로젝트 개요 본문

사투리 인식 및 표준어 변환 음성모델

워크플로우 =

[ 사투리(Speech) → Audio Recognition → Text(사투리-표준어 출력) → TTS → 표준어(Speech) ]

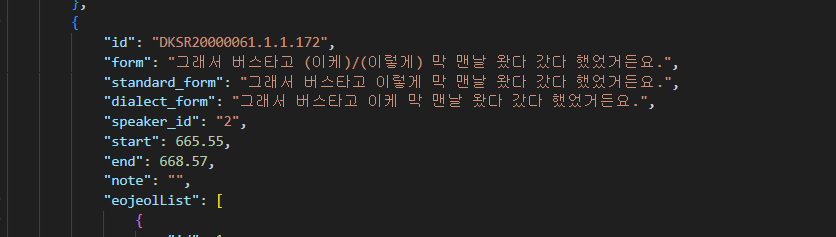

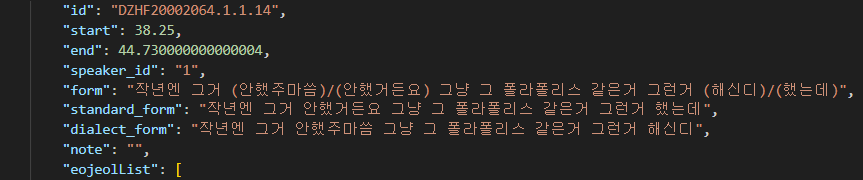

AI-hub에 있는 경상도 방언발화 데이터 이용

샘플 텍스트 데이터만 잠깐 봤는데 생각보다 표준어(standard form)랑 사투리(dialect form)랑 어휘 면에서 큰 차이가 없는 것 같다는 생각이 든다. 거의 비슷한데 아래 저런 차이정도? 오디오로 함께 들으면 억양차이가 느껴지겠지만 어휘에서도 차이가 큰 사투리 데이터를 사용하는게 좀 더 극적인 효과가 날 것 같긴 해서,,

지역 면에서 제주도 데이터도 고려해보는 것이 나쁘지 않겠다는 생각이 듦

사투리 텍스트를 우선 표준어 텍스트로 번역해주는 NLP 생성 모델 구축이 모델 성능에서 그래도 핵심이 될 것이라 생각함!

초기와 말미의 오디오 딥러닝 부분에서는 사투리 억양을 추가한다던지 등의 Style Transfer가 추가될 수도 있겠다는 생각이 들지만, 우선적으로 사투리 -> 표준어 변환을 할 수 있는 모델의 이론을 공부하기 위한 논문들을 먼저 읽으려고 한다.

< 읽어야 할 논문 (정리중)> :

https://arxiv.org/abs/1910.13461

BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension

We present BART, a denoising autoencoder for pretraining sequence-to-sequence models. BART is trained by (1) corrupting text with an arbitrary noising function, and (2) learning a model to reconstruct the original text. It uses a standard Tranformer-based

arxiv.org

https://arxiv.org/abs/2401.05632

Natural Language Processing for Dialects of a Language: A Survey

State-of-the-art natural language processing (NLP) models are trained on massive training corpora, and report a superlative performance on evaluation datasets. This survey delves into an important attribute of these datasets: the dialect of a language. Mot

arxiv.org